El 17 de junio de 1972 unos ladrones entraron a la sede del partido demócrata en Washington, el edificio Watergate. Los llamados “fontaneros” eran espías y delincuentes al servicio del entonces presidente de los Estados Unidos, Richard Nixon. La misión de estos gánsteres a sueldo era comprobar que los micrófonos que espiaban al partido rival seguían funcionando correctamente.

Cuando los periodistas Bernstein y Woodward se enteraron del incidente, decidieron seguirlo muy de cerca, porque, aunque la certeza del espionaje por parte de Nixon era clara y evidente, demostrarlo resultaría una tarea muy ardua. Por suerte para la democracia, ambos periodistas de investigación siguieron durante meses las pruebas y las filtraciones, entre ellas su famosa fuente conocida como “garganta profunda”, y consiguieron derrotar al fraude y la mentira que acabó con la dimisión de Nixon el 9 de agosto de 1974.

Años más tarde, en el 2018, otro escándalo político estalló en Estados Unidos. En este caso, la manipulación había sido puesta en marcha por la consultora privada británica Cambridge Analytica, quien fue acusada de la adquisición de forma indebida de información personal de 50 millones de usuarios de la red social Facebook en Estados Unidos. Según investigaciones llevadas a cabo por el New York Times, esos datos privados fueron utilizados para manipular psicológicamente a los votantes en las elecciones de 2016, donde Donald Trump resultó el presidente electo. Esta vez el fraude cibernético no tuvo mayores consecuencias para los responsables, al contrario, benefició a un partido.

Alucinaciones de la IA generativa

La sofisticación de las técnicas de manipulación para minar o ganar la confianza de los votantes en fechas cercanas a las elecciones ha dado un salto cualitativo con la consolidación de la llamada inteligencia artificial generativa (IAG).

Esta nueva generación de IA, basada en imágenes y lenguajes naturales, está causando estragos ya en las fases previas a las elecciones por la facilidad y el bajo costo que supone la creación y propagación de noticias, audios y videos falsos personalizados. El peligro que entrañan estas alucinaciones creadas por la IA generativa es que son prácticamente imposibles de detectar por los sentidos humanos, por la gran similitud que guardan con la realidad conocida.

La sofisticación de las técnicas de manipulación para minar o ganar la confianza de los votantes ha dado un salto cualitativo.

Mette Frederiksen, primera ministra danesa, cerró en junio de 2023 una de sus comparecencias públicas en el parlamento confesando que había utilizado ChatGPT para redactar parte de su discurso. Dijo: “Lo que acabo de leer no ha sido enteramente escrito por mí ni por ningún otro ser humano. Ha sido escrito por una inteligencia artificial, lo que es a la vez fascinante y terrorífico”. Con la IA generativa se pueden producir textos, imágenes y hasta videos con contenidos “diseñados” por sus autores.

Bots creíbles y manipulables

Si se quiere prever el impacto negativo que podría tener el uso manipulado de diferentes piezas sintéticas producidas por una IA generativa en la ola de elecciones que se llevarán a cabo durante 2024 en todo el mundo, conviene echar la mirada hacia elecciones anteriores. Veamos el papel concreto que han jugado los llamados bots, tanto en Facebook como en Twitter (ahora X), en las elecciones de Estados Unidos en 2016 y en las de Francia un año después.

¿Cuáles fueron los principales ingredientes que permitieron deformar las campañas electorales de los dos países? La distorsión informativa e incluso comunicativa de la realidad fue posible gracias a la difusión masiva de mensajes personalizados y falsos, dirigidos a grupos específicos de la población. En concreto, esta manipulación del ecosistema electoral se produjo por la combinación de las técnicas de microtargeting (micro focalización/segmentación), junto con el uso sistemático y automatizado de los bots en las redes sociales. El objetivo estaba claro: ensalzar a un candidato y erosionar la confianza en el resto de sus oponentes.

Los bots en campañas políticas

En principio, un bot (también conocido bajo el nombre de robot, robot social, bot de redes sociales, bot de spam social o cuenta sybil) se define como una cuenta de redes sociales controlada predominantemente por un software que trata de replicar la conducta humana en las plataformas en las que actúa. Los bots pueden generar y publicar contenidos falsos que difunden a una gran cantidad de usuarios, en un tiempo récord.

Por ejemplo, diferentes investigaciones que evaluaron y siguieron el comportamiento de los bots en la red social de Twitter durante las elecciones de 2016 en Estados Unidos, han llegado a la conclusión de que los humanos reaccionaron más ante los posts (publicación escrita) creados directamente por otros humanos, mientras que los bots fueron más susceptibles de responder a otros bots.

La creación y propagación de noticias, audios y videos falsos personalizados es fácil y de bajo costo.

Ahora bien, un fenómeno muy diferente se observó al analizar los llamados retweets1, ya que no se encontró una diferencia estadísticamente significativa entre la cantidad de retweets que los humanos produjeron al compartir contenido generado por otros humanos o por los bots. De estos datos y de este comportamiento se infiere que los robots sociales resultaron exitosos al insertar y compartir sus mensajes generados de manera automática en las plataformas de comunicación humana.

Otro dato importante o patrón anómalo que se detectó, tanto en las elecciones de Estados Unidos como en las francesas, fue que los picos de mensajes en el contenido producido por los bots parecían preceder a los picos en la difusión de mensajes generados por humanos.

Habría que agregar que muchas de las cuentas de bots detectadas en ambas elecciones eran las mismas, lo que lleva a concluir que pueda existir algo así como un mercado negro de robots sociales que son reutilizables para engendrar desinformación política.

El fenómeno del dividendo del mentiroso

Es cada día más difícil detectar, con las técnicas actualmente disponibles, lo que es verídico de lo que ha sido manipulado intencionalmente. Los profesores de derecho Robert Chesney2 y Danielle Citron3 han denominado a este fenómeno, en el que el mentiroso intenta evadir su responsabilidad, el “dividendo del mentiroso”. Esta teoría se basa en la hipótesis de que cuando la gente está expuesta de manera continua a contenidos ultrafalsos, que son cada vez más realistas, el alegato de un político de que un contenido real fue generado por una IA también se vuelve más convincente.

La tónica dominante es que este tipo de contenidos ultrafalsos en forma de bots, textos, imágenes, audios, videos y otros formatos, se sigan utilizando por diferentes actores para generar desconfianza y tratar de ganar adeptos a su causa. De tal manera resulta muy factible, de cara a futuras elecciones, que un candidato o candidata niegue la falsedad de un contenido real, respaldado por partidarios que defienden su posición ante el público.

Los bots pueden generar y publicar contenidos falsos, para una gran cantidad de usuarios, en tiempo récord.

Probar que la fuente es auténtica

Dada la importante ola de elecciones que tendrán lugar este 2024, ya no hay que preocuparse solamente por detectar qué tipo de bots podrían programarse de manera consciente para manipular y generar desconcierto en las redes sociales, sino que también es preciso hacerse cargo de los usos malintencionados que ya se le están dando a los contenidos sintéticos y falsos producidos por la IA generativa.

En este sentido, ya existen herramientas como Botometer, aplicación reconocida por su gran eficacia en detectar bots sociales y otras técnicas de manipulación en las redes sociales. Los esfuerzos por desarrollar otras herramientas similares para la detección de contenidos falsos producidos por la IA generativa no están resultando, de momento, tan efectivos.

Ante este panorama se puede recurrir a otro tipo de alternativas. Una de ellas se basa, no tanto en detectar lo que es falso, sino en certificar lo que es auténtico, es decir, contextualizar la fuente de la información. Al fin y al cabo, la tecnología puede crear contenido falso y su uso puede ser objeto de manipulación, pero el peligro real es cómo vincular ese contenido o contenidos con algún tipo de narrativa que tenga coherencia en un periodo de tiempo prolongado.

Como dijo Ben Bradlee, director de The Washington Post durante el caso Watergate, que hasta el momento es el hito más importante que ha celebrado el periodismo de investigación en su lucha por mantener los ideales democráticos, “la verdad, por mala que sea, nunca es tan peligrosa como una mentira a largo plazo” (The truth, no matter how bad, is never as dangerous as a lie in the long run).

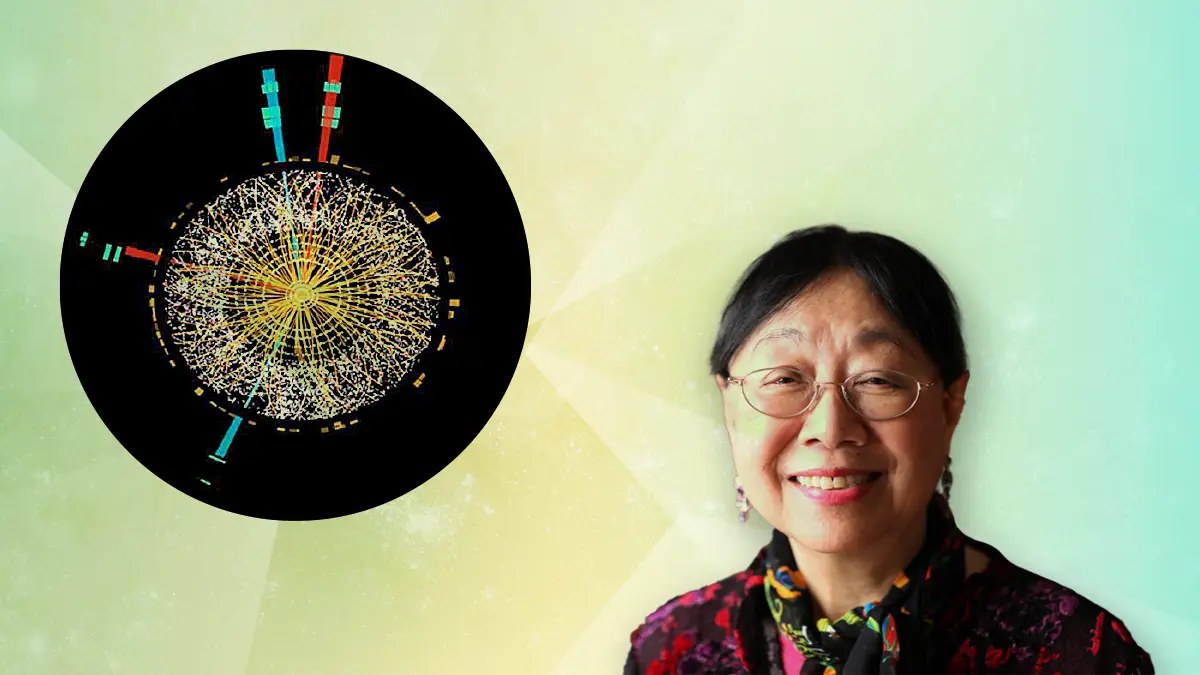

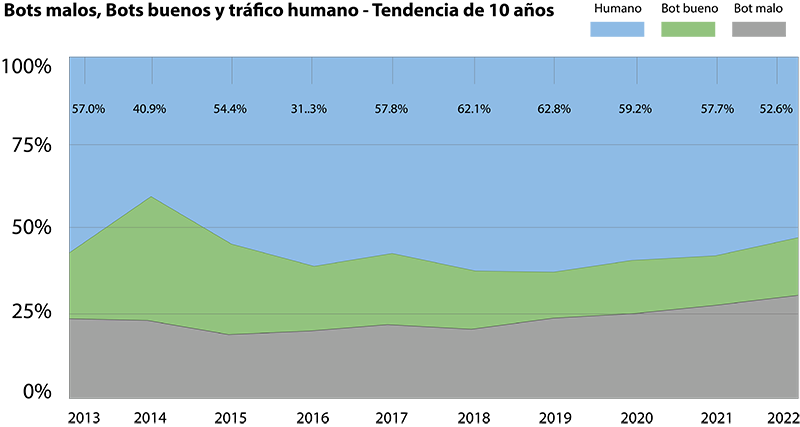

Porcentaje del tráfico generado en Internet por bots manipuladores (en gris), bots de recopilación de información (en verde), y usuarios humanos (en azul). Ya casi la mitad del tráfico en Internet es producido por bots, 30% por bots de manipulación.

Fuente:2023 Imperva Bad Bot Report | Resource Library. (2023, 26 mayo). Resource Library. https://www.imperva.com/resources/resource-library/reports/2023-imperva-bad-bot-report/